Big data : qu’est-ce que vous devez apprendre ? Un petit guide pour les débutants

Big data : comment commencer ?

Partout, nous disons que c’est l’avenir, que nous devons aller au big data. Dès que possible.Très bon. Mais alors, quoi commencer ? Qu’ est-ce qui doit être appris de toute urgence ? Que devez-vous former pour devenir un maître du Big Data ?

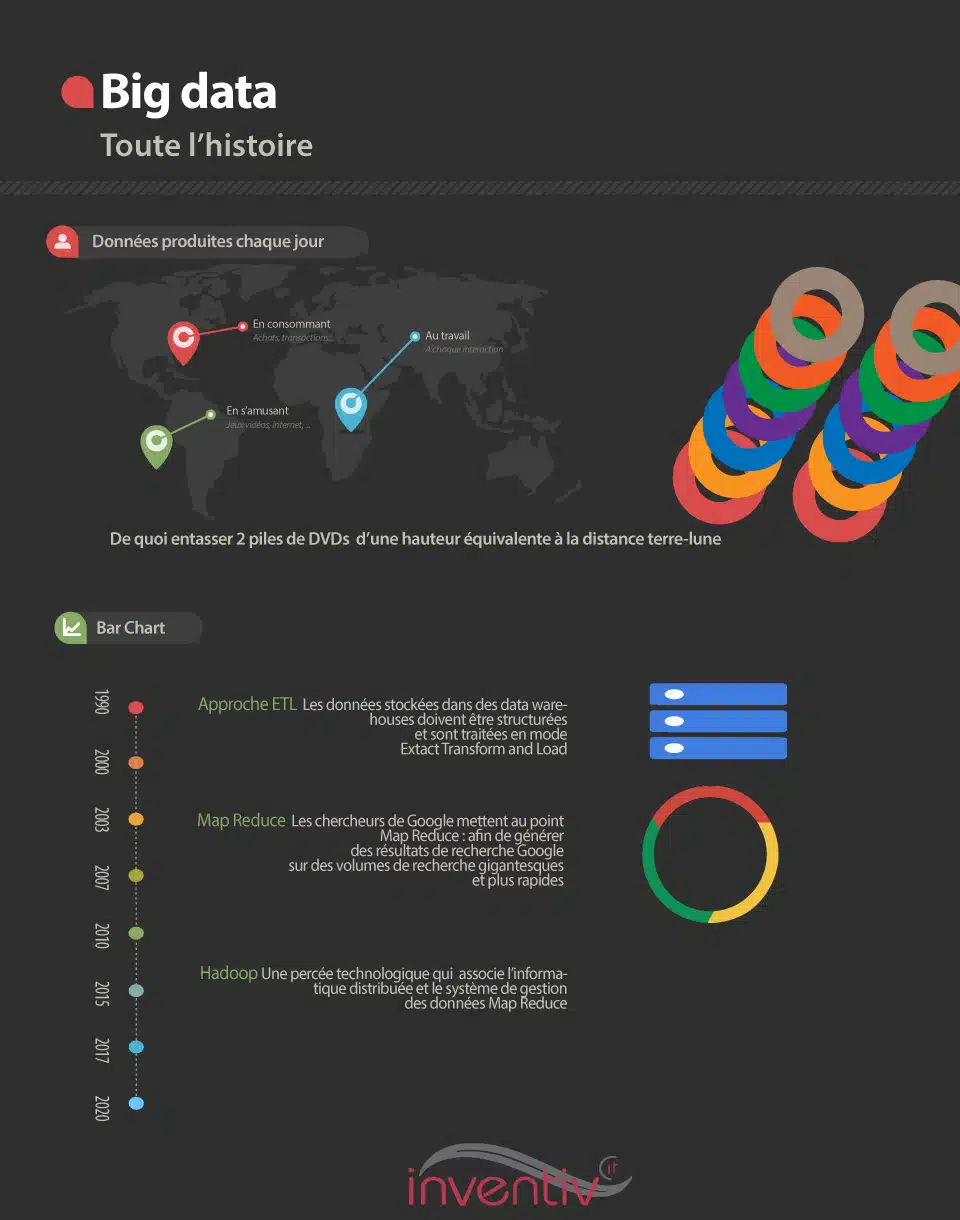

Plutôt que de proposer ici un inventaire des formations typiques, avec des titres qui maintiendront ce sentiment de mots-clés branchés, nous avons préféré vous raconter l’histoire du Big Data. Comment et pourquoi on en est arrivé à ça ?

D’ où vient ce terme et quels développements technologiques le monde du big data devrait-il exploser ?

En ayant une meilleure vue de ce qu’est le Big Data, vous déduisez ce que vous devez apprendre pour devenir un as du sujet, et surtout ce que vous devez apprendre vous-même.

Big data : quelle est la différence par rapport à l’analyse des données ?

La première question est celle qui nous permet de comprendre la nouveauté de cette affaire. Quelle est la différence entre le Big Data et la bonne analyse des données anciennes et les cours de statistique que nous avons organisés au lycée — et parfois au-delà ?

En fait, la nouveauté vient d’Internet et le fait que toutes les données sont maintenant produites instantanément de tous les côtés.

Selon IBM, l’espèce humaine produit 2,5 quintillions (25 milliards de milliards) de bits de données chaque jour, manger, dormir, jouer, travailler, etc.Ceci est l’équivalent de 2 piles de DVD placés les uns sur les autresdont la hauteurvarie de la terre… à la lune !Sachant, par conséquent, que ces DVD contiennent tout, des textes que nous envoyons, aux photos que nous prenons, aux données de tous les et les machines qui communiquent les uns avec les autres, ce qui explique pourquoi les données sont devenues , dans un langage commun, si « grandes » .

Et donc, quand les gens parlent de ces mégadonnées , ils pensent généralement au fait que nous allons prendre une grande partie de ces données, les analyser et en déduire quelque chose d’intéressant.

En fait, c’est bien plus que ça.

Le Big Data est bien plus que cela.

Big Data, il se compose également de :

- pour prendre de grandes quantités de données provenant de différentes sources ,

- d’ utiliser ces données de types très différents, produites à des rythmes différents sans nécessairement avoir à les « traduire » dans des formats spécifiques.

- pour stocker ces données afin qu’elles puissent être utilisées en même temps pour un tas d’analyses différentes à des fins différentes.

- et de faire tout cela très rapide, et parfois même… en temps réel.

Au tout début, nous avons parlé du 3V ou VVV : volume (grandes quantités), variété (différents types de données) et vitesse (vitesse de traitement).

Big Data vs. entrepôt de données

Mais ce que l’acronyme VVV n’a pas mis en perspective , c’est cette innovation centrale qui signifie que les données n’ont pas besoin d’être systématiquement « transformées » pour être analysées.

Ce traitement « non destructif » signifiait que les organisations pouvaient désormais analyser les mêmes lots de données à des fins différentes et extraire ces données auprès de sources qui les avaient elles-mêmes collectées à des fins encore différentes.

Une nouvelle approcheest donc apparue, très différente de celle que nous connaissions à l’époque autour de l’ exploration de donnéeset des entrepôts de données .

L’ entrepôt de données classique a été conçu pour un usage donné. Les données ont été structurées et convertis dans des formats spécifiques. Les données initiales sont nécessairement détruites dans le processus.

Nous parlions du processus ETL : « extraire, transformer et charger ».

L’ approche ETL se limite donc à des analyses spécifiques pour des données spécifiques. C’était parfait si toutes vos données existaient dans votre système de transaction. Mais ce n’est plus si terrible, quand vous connaissez toutes les données qui existent ici et là dans notre monde hyper-connecté, produisant tous les quintillions de données mentionnées ci-dessus.

C’ est donc l’une des premières choses à apprendre dans le monde duBig Data : — regardez dehors, demandez quelles données sont disponibles en dehors du système — regardez les données disponibles pour tout le monde, les fameuses données ouvertes — demandez comment nous pourrions les connecter, les croiser, ce que nous apprendrions de ces avec les données que nous avons déjà.

La fin des entrepôts de données ?

Ne croyez pas que le Big Data fait des données entrepôts obsolètes . Les systèmes Big Data vous amènent à travailler avec des données non structurées, mais le type de résultats de requête que vous obtenez est loin de la sophistication des entrepôts de données.

L’ entrepôt de données est conçu pour une analyse approfondie des données , ce qui est rendu possible précisément parce que les données ont été transformées et planifiées dans un format spécifique.

fournisseurs d’entrepôts de données travaillent depuis des années pour optimiser leurs moteurs de recherche afin de répondre aux attentes typiques d’une entreprise spécifique. Les

Si vous ou votre organisation êtes un spécialiste de la chose, ne vous sentez pas en retard ou dépassé. On ne parle pas exactement de la même chose.

Big Data vous permet d’analyser beaucoup plus de données provenant de nombreuses sources, maisavec une résolution moins fine. Le

Le Big Data est un monde impressionniste qui aura toujours besoin de l’hyperréalisme des entrepôts de données.

C’ est pourquoi nous sommes condamnés à vivre avec les entrepôts de données traditionnels et le nouveau style de traitement appelé Big Data.

Le Big Data ne consiste donc pas à désapprendre ce que vous avez appris de la formation dans l’entrepôt de données. Le Data Scientist n’a pas nécessairement à remplacer l’ingénieur de Business Intelligence.

Au lieu de cela, il sera nécessaire que l’entreprise soulève la question de savoir comment s’assurer que les deux s’enrichissent mutuellement. Et cela aussi doit être appris et étudié.

Percées technologiques derrière le Big Data

C’ est pour le côté philosophique et organisationnel.

Mais il y a aussi la dimension technologique . Encore une fois, le Big Data est basé sur une révolution qu’il faut comprendre. Et à laquelle il est nécessaire de s’adapter grâce à une formation ad hoc et à l’apprentissage.

Contrairement à 3V , le Big Data est 3V 1U : volume, variété, vitesse et plus encore : utilisation non destructive des données.

Pour y parvenir, les défis technologiques devaient être atteint avec succès.

En premier lieu, le développement de systèmes informatiques distribués : c’est le domaine de Hadoop , par exemple.

Il a également fallu une méthode pour mettre en perspective des données disparates : c’est le territoire de Mareduce de Google ou plus récemment Apache Spark

Enfin, il a fallu un principe d’infrastructure nuage/Internet pour accéder aux données et les utiliser comme souhaité.

Jusqu’ à douze ans de retard, il était impossible de manipuler des volumes de données comme ceux dont nous avons besoin aujourd’hui. À l’époque, nous avons certainement eu l’impression que ces volumes de données étaient énormes et que nos entrepôts de données étaient capables d’un traitement massif.

Mais les limites de ces dispositifs de l’époque en termes de localisation et de stockage, de puissance de calcul et d’impossibilité de traiter des données de différents types ne nous ont pas permis de faire face à unnouveau contexte : celui d’un monde où, grâce à la Internet, les donnéessont produites et interconnectées partout, dans toutes les directions et à tout moment.

Carte Réduire

Vers 2003, des chercheurs de Google ont développé MapReduce.Cette technique de programmation simplifie le traitement des jeux de données en réduisant d’abord les données à des ensembles de paires clé/valeur, puis en effectuant des calculs sur des données avec des clés similaires pour réduire tout à une seule valeur. Chaque « gros morceau » de données pourrait être traité en parallèle sur des centaines, voire des milliers de machines peu coûteuses. Cette technique de traitement parallèle à grande échelle a permis à Google de générer des résultats de recherche sur des volumes de données incroyablement plus importants qu’auparavant, et ceci, en allant plus vite.

Google est à l’origine des deux percées technologiques qui ont rendu possible le Big Data :

Le premier était Hadoop, qui se compose de deux services clés :

- un système de stockage de données , utilisant HDFS (Hadoop Système de fichiers distribués)

- un système de traitement de données parallèle , utilisant une technique appelée Map Reduce.

Hadoop s’exécute sur un ensemble de serveurs dans une architecture rien partagée.

Les serveurs peuvent être ajoutés ou supprimés à volonté dans un cluster Hadoop. Le système détecte et résout les problèmes sur chaque serveur. Hadoop, en d’autres termes, « auto-guérit ». Par conséquent, il peut continuer à fournir des données et à fonctionner à grande échelle en exécutant des tâches nécessitant des performances élevées, malgré des changements ou des échecs.

Sa véritable valeur ajoutée est encore ailleurs : elle provient des adds-ons et des add-ons personnalisables de sa technologie. Hadoop propose des projets supplémentaires qui ajoutent des fonctionnalités à la plateforme :

- Hadoop Common : Ce sont les outils de base nécessaires pour d’autres projets Hadoop

- Chukwa : un système de récupération de données pour gérer de grands systèmes distribués.

- HBase : une base de données distribuée et évolutive qui prend en charge stockage de données structurées pour les grandes tables.

- HDFS : un système distribué qui fournit un accès rapide aux données des applications

- Hive : infrastructure d’entrepôt de données qui fournit une synthèse des données et un système de requêtes ad hoc.

- MapReduce : une infrastructure logicielle pour les processus de jeux de données distribués

- Pig : importants un langage et un cadre pour l’exécution de processus parallèles.

- ZooKeeper : un service de coordination haute performance pour les applications distribuées.

La mise en œuvre d’une plateforme Hadoop inclut nécessairement certains de ces sous-projets.

Par exemple, de nombreuses organisations choisissent d’utiliser HDFS comme système de gestion de fichiers distribué principal et HBase comme base de données pouvant stocker des milliards de colonnes de données. Et l’utilisation de MapReduce (ou Spark) est alors presque évidente car elle apporte vitesse et agilité à la plateforme Hadoop.

Avec MapReduce, les développeurs peuvent créer des programmes qui traitent des volumes massifs de données non structurées en parallèle via un cluster de processeurs distribués sur indépendant. Le framework MapReduce est divisé en deux espaces fonctionnels :

- Map , une fonction qui distribue le travail à différents nœuds dans les clusters d’ordinateurs.

- Reduce , une fonction qui rassemble le travail et résume les résultats en une valeur simple.

L’ un des principaux avantages de Map Reduce est qu’il est tolérant aux pannes ou tolérant aux pannes.Comment fait-il ça ? Il « surveille » chaque nœud du cluster régulièrement. Celui-ci est censé retourner périodiquement un travail complet avec des mises à jour de « status ». Si un nœud reste silencieux plus que nécessaire, un nœud maître le signale et réaffecte le travail aux autres nœuds du cluster.

Construit à l’origine pour indexer le moteur de recherche Nutch, Hadoop est maintenant utilisé dans toutes les grandes industries pour la quantité des tâches Big Data.

En d’autres termes, grâce au système informatique distribué HDFS et YARN (Yet Another Resource Negotiator), le logiciel permet à l’utilisateur de traiter de gigantesques volumes de données répartis sur des milliers d’ordinateurs, comme s’il s’agissait d’une énorme machine.

Comment adapter cela à votre cas ? L’histoire de ces sauts technologiques est inévitablement contraignante pour vous et votre organisation.

Vous ne connaissez pas l’informatique distribuée ? Il est urgent de mieux le comprendre et de former vous-même ou vos équipes.

Quant aux outils, l’histoire de Hadoop montre à quel point sa logique est imposée à l’univers du Big Data. Son univers ne doit pas vous rester étranger. Pensez-y.

Mais l’histoire n’est pas finie.

En 2009, les chercheurs de l’Université de Californie à Berkeley ont développé Apache Spark, une alternative à MapReduce.Spark effectue ses calculs en parallèle en utilisant stokage en mémoire, il est jusqu’à 100 fois plus rapide que MapReduce. Spark peut être utilisé seul ou à l’intérieur de Hadoop.

Même avec Hadoop, vous avez toujours besoin d’un moyen de stocker et d’accéder aux données.

C’ est généralement ce que les bases de données NoSQL telles que Mongo DB, CouchDG ou Cassandra sont utilisées pour le traitement de données non structurées ou semi-structurées et distribuées sur plusieurs machines.

Contrairement aux entrepôts de données, où des quantités massives de données sont envoyées à un format unifié et stockées dans un seul magasin de données, ces outils ne modifient pas la nature ou l’emplacement des données d’origine — les courriels restent des courriels, les données du capteur restent les données du capteur — et peuvent être stockés pratiquement n’importe où.

Un problème reste : avoir des quantités massives de données dans les bases de données NoSQL installées dans des clusters de machines n’est pas très utile tant que vous ne faites rien. C’est là que l’analyse des Big Data intervient.

Des outils tels que Tableau, Splunk et Jasper BI vous permettent d’analyser ces données pour identifier des modèles, extraire des significations et révèlent de nouvelles perspectives. Ce que vous en faites dépendra de vos besoins.

Encore une fois, les compétences dans ces analyses sont particulièrement demandées. Cela fait partie des compétences à acquérir.

Notez également que la maîtrise des bases de données NoSQL semble importante, sinon indispensable. Connaître et maîtriser le NoSQL semble donc essentiel pour le monde du Big Data. Bien que… dans cet article, vous verrez que SQL est de retour en vigueur dans l’univers du Big Data.

À suivre, alors…

Besoin d’un diagnostic plus précis ?

Qu’ est-ce que vous avez besoin d’apprendre ? Qui a besoin d’être formé à quoi dans votre organisation ? Contactez-nous pour un diagnostic précis.

Source : InfoWorld. Article écrit par Galen Gruman (rédacteur en chef), Steve Nunez (rédacteur en chef), Frank Ohlhorst et Dan Tynan.

Tag : Le Big Data : c’est quoi ?